「サリエンシー」の版間の差分

細編集の要約なし |

細編集の要約なし |

||

| 1行目: | 1行目: | ||

英語名:saliency | 英語名:saliency | ||

類語・同義語:顕著性、サリエンス(salience)。 | |||

[[感覚]]刺激が刺激の時間的または空間的配置によって[[ボトムアップ性注意]]を誘引する特性を「サリエンシー」と呼ぶ。「サリエンシー・マップ」とは、視覚刺激のサリエンシーを計算して特徴に依存したい単一の二次元スカラー量として表現したもののことを指す。これは計算論的概念であって、脳にサリエンシー・マップが表現されている保証はない。しかしながら、サリエンシー・マップが表象されている部分としてこれまでに、[[一次視覚野]]([[V1]])、[[上丘]]、[[視床枕]]、[[LIP]]、[[FEF]]などがその候補としてあげられている。 | |||

== サリエンシーとは == | == サリエンシーとは == | ||

| 15行目: | 15行目: | ||

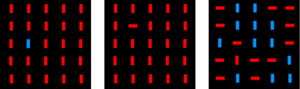

[[Image:Masatoshiyoshida_fig_1.png|thumb|300px|'''図1.視覚探索''']] | [[Image:Masatoshiyoshida_fig_1.png|thumb|300px|'''図1.視覚探索''']] | ||

サリエンシーは、心理学的研究においては、[[視覚探索]]における[[pop-out]]という概念と関連している。 | |||

図1の三つの刺激でそれぞれ仲間はずれの要素を見つけなさい、と問われたとしたら、左と真ん中の二つの図ではひとめで見つかるのに対して、右の図ではなかなか難しい。これは左の図では色特徴でpop-outするから、真ん中の図では傾きの特徴でpop-outするから、と表現される。 | 図1の三つの刺激でそれぞれ仲間はずれの要素を見つけなさい、と問われたとしたら、左と真ん中の二つの図ではひとめで見つかるのに対して、右の図ではなかなか難しい。これは左の図では色特徴でpop-outするから、真ん中の図では傾きの特徴でpop-outするから、と表現される。 | ||

このような知見を元にしてAnn | このような知見を元にしてAnn Triesmanは注意の「[[特徴統合理論]]」(feature integration theory)を作り上げた<ref><pubmed> 7351125 </pubmed></ref>。特徴統合理論では、視野像は各特徴(輝度、色、傾きなど)ごとに並行して処理され、それらの特徴が最終的に統合される。よって、図1左の色のpop-out刺激では、色特徴の処理の段階で仲間はずれを検出することが出来るので処理が速いのだが、図1右のconjunction searchでは統合された情報を探索しなければならないために処理が遅くなる、と説明される。 | ||

同様な現象は他のモダリティー、たとえば音刺激でも見られる。たとえば聴覚でのoddball taskでは、ピ、ピ、ピと連続する純音刺激に違う周波数の純音が混ざったり、または音が鳴らなかった場合にはその時に注意が誘引される。この場合は空間ではなくて、時間的配列がボトムアップ性注意を誘引する例と言える。 | 同様な現象は他のモダリティー、たとえば音刺激でも見られる。たとえば聴覚でのoddball taskでは、ピ、ピ、ピと連続する純音刺激に違う周波数の純音が混ざったり、または音が鳴らなかった場合にはその時に注意が誘引される。この場合は空間ではなくて、時間的配列がボトムアップ性注意を誘引する例と言える。 | ||

| 46行目: | 46行目: | ||

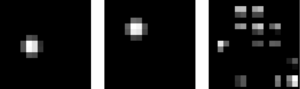

[[Image:Masatoshiyoshida_fig_2.png|thumb|300px|'''図2.サリエンシー・マップ''']] | [[Image:Masatoshiyoshida_fig_2.png|thumb|300px|'''図2.サリエンシー・マップ''']] | ||

この計算論モデルはC++ソフトウェアとして、[http://ilab.usc.edu/toolkit/ 南カリフォルニア大学Ittiラボ] | この計算論モデルはC++ソフトウェアとして、[http://ilab.usc.edu/toolkit/ 南カリフォルニア大学Ittiラボ]より、ソースが[[wikipedia:ja:GNU General Public License|GNU General Public License]]に基づいて入手できるようになっている。 | ||

このソフトウェアを使って図1の画像のサリエンシーを計算したのが図2となる。 | このソフトウェアを使って図1の画像のサリエンシーを計算したのが図2となる。 | ||

| 66行目: | 66行目: | ||

== サリエンシー・マップの応用 == | == サリエンシー・マップの応用 == | ||

画像や映像を見ているときの[[視覚探索]]をサリエンシー・マップによって予測するという一連の研究がある。そのなかではたとえば視覚探索時の[[眼球運動]]のデータから[[ADHD]]患者や[[パーキンソン病]]患者を分類することに成功したもの<ref name=ref9><pubmed> 22926163 </pubmed></ref>や[[wikipedia:ja:マカクザル|マカクザル]]の視覚探索時の眼球運動のデータから第一次視覚野損傷の影響を解明したもの<ref name=ref10><pubmed> 22748317 </pubmed></ref>などがある。 | |||

== 関連項目 == | == 関連項目 == | ||

2013年1月7日 (月) 16:00時点における版

英語名:saliency

類語・同義語:顕著性、サリエンス(salience)。

感覚刺激が刺激の時間的または空間的配置によってボトムアップ性注意を誘引する特性を「サリエンシー」と呼ぶ。「サリエンシー・マップ」とは、視覚刺激のサリエンシーを計算して特徴に依存したい単一の二次元スカラー量として表現したもののことを指す。これは計算論的概念であって、脳にサリエンシー・マップが表現されている保証はない。しかしながら、サリエンシー・マップが表象されている部分としてこれまでに、一次視覚野(V1)、上丘、視床枕、LIP、FEFなどがその候補としてあげられている。

サリエンシーとは

もし夜空に月が光っていれば月にすぐに目が向くだろう。これは月が目立つ(salient)からだ。このように感覚刺激がボトムアップ性注意を誘引する特性を「サリエンシー」と呼ぶ。 夜の月がsalientであるのは周りの空と比べて明るいからであって、昼の月はsalientではない。つまり、サリエンシーは刺激の時間的または空間的配置によって決定づけられるものであって、その刺激自体の特性ではない。明るいスクリーンに暗い部分があればそこはsalientになる。つまり刺激強度が高いこと(たとえば輝度が高いこと)とサリエンシーが高いことは等価ではない。

しかし、一般名詞としてsalience / saliencyという言葉を(物理的な強度と対比させて)心理的な強度自体を表していることもあり、かならずしも上記の用法で統一されているとは言えない。

視覚探索

サリエンシーは、心理学的研究においては、視覚探索におけるpop-outという概念と関連している。

図1の三つの刺激でそれぞれ仲間はずれの要素を見つけなさい、と問われたとしたら、左と真ん中の二つの図ではひとめで見つかるのに対して、右の図ではなかなか難しい。これは左の図では色特徴でpop-outするから、真ん中の図では傾きの特徴でpop-outするから、と表現される。

このような知見を元にしてAnn Triesmanは注意の「特徴統合理論」(feature integration theory)を作り上げた[1]。特徴統合理論では、視野像は各特徴(輝度、色、傾きなど)ごとに並行して処理され、それらの特徴が最終的に統合される。よって、図1左の色のpop-out刺激では、色特徴の処理の段階で仲間はずれを検出することが出来るので処理が速いのだが、図1右のconjunction searchでは統合された情報を探索しなければならないために処理が遅くなる、と説明される。

同様な現象は他のモダリティー、たとえば音刺激でも見られる。たとえば聴覚でのoddball taskでは、ピ、ピ、ピと連続する純音刺激に違う周波数の純音が混ざったり、または音が鳴らなかった場合にはその時に注意が誘引される。この場合は空間ではなくて、時間的配列がボトムアップ性注意を誘引する例と言える。

サリエンシー・マップ(saliency map)

特徴統合理論はあくまで心理学的な理論であったが、計算論的立場からどのようにボトムアップ性注意が計算されているかを説明するモデルとして「サリエンシー・マップ」が提唱された[2]。

サリエンシー・マップとは、特徴に依存しない視覚刺激のサリエンシーをスカラー量として計算して、二次元マップとして表現したもののことを指す。

サリエンシー・マップの機能的な特徴としては以下の二つがあげられる。

- 平行処理:特徴統合理論からの影響を受けているため、サリエンシーはまず各特徴ごとに計算されて、特徴マップを作る。

- Winner-take-allルール:これら複数の特徴マップが足しあわされて計算されたサリエンシー・マップの中からいちばんサリエンシーの高い部分が選択される。

Koch and Ulman 1985[2]においてはあくまで計算の原理のモデルであったのだが、それを実際の画像から計算できるようなモデルとして実現したのがItti, Koch and Neiburによるサリエンシー計算論モデルだった[3]。

このモデルのアルゴリズムレベルでの特色としては、

- 各特徴ごとのサリエンシーを計算するため、center-surround抑制を用いる。

- さまざまな解像度(pyramids)でこの作業を平行して行う(画像処理の分野でのmulti-scale representationに対応) 。

- 以上の操作を繰り返して正規化する(iterative normalization)。

がある 。

この計算論モデルはC++ソフトウェアとして、南カリフォルニア大学Ittiラボより、ソースがGNU General Public Licenseに基づいて入手できるようになっている。

このソフトウェアを使って図1の画像のサリエンシーを計算したのが図2となる。

ほかにもMatlabでのサリエンシー・マップを計算するプログラムとして以下のものがwebから入手可能である。

- SaliencyToolbox

- Graph-Based Visual SaliencyおよびItti, Koch, Nieburのサリエンシー・マップ

- Matlab codes for measuring image saliency

Itti, Koch and Neibur[3]以降、サリエンシー・マップはさまざまな実装が報告されており、たとえば三次元への拡張、トップダウン注意への拡張などcomputational visionにおいて重要な分野の一つとなっている。

サリエンシーの脳内表象

サリエンシー・マップはあくまで計算論的概念であるので、脳にサリエンシー・マップが表現されている保証はない。オリジナルの定義からすればサリエンシー・マップは単一のものであるはずだが、複数の処理レベルのサリエンシー・マップが脳内で分散して表現されていると主張しているものもある (たとえば[4])。

サリエンシーが表象されている部分としてこれまでに、V1[5]、上丘[6]、視床枕[7]、LIP[8]、FEF[9]、V4[10]などがその候補として挙げられている。

サリエンシー・マップの応用

画像や映像を見ているときの視覚探索をサリエンシー・マップによって予測するという一連の研究がある。そのなかではたとえば視覚探索時の眼球運動のデータからADHD患者やパーキンソン病患者を分類することに成功したもの[11]やマカクザルの視覚探索時の眼球運動のデータから第一次視覚野損傷の影響を解明したもの[12]などがある。

関連項目

参考文献

- ↑

Treisman, A.M., & Gelade, G. (1980).

A feature-integration theory of attention. Cognitive psychology, 12(1), 97-136. [PubMed:7351125] [WorldCat] - ↑ 2.0 2.1

Koch, C., & Ullman, S. (1985).

Shifts in selective visual attention: towards the underlying neural circuitry. Human neurobiology, 4(4), 219-27. [PubMed:3836989] [WorldCat] - ↑ 3.0 3.1 L. Itti, C. Koch, & E. Niebur

A Model of Saliency-Based Visual Attention for Rapid Scene Analysis.

IEEE Transactions on Pattern Analysis and Machine Intelligence: 1998, 20(11):1254-1259. - ↑

Navalpakkam, V., & Itti, L. (2005).

Modeling the influence of task on attention. Vision research, 45(2), 205-31. [PubMed:15581921] [WorldCat] [DOI] - ↑

Li, Z. (2002).

A saliency map in primary visual cortex. Trends in cognitive sciences, 6(1), 9-16. [PubMed:11849610] [WorldCat] - ↑

Kienzle, W., Franz, M.O., Schölkopf, B., & Wichmann, F.A. (2009).

Center-surround patterns emerge as optimal predictors for human saccade targets. Journal of vision, 9(5), 7.1-15. [PubMed:19757885] [WorldCat] [DOI] - ↑

Robinson, D.L., & Petersen, S.E. (1992).

The pulvinar and visual salience. Trends in neurosciences, 15(4), 127-32. [PubMed:1374970] [WorldCat] [DOI] - ↑

Gottlieb, J.P., Kusunoki, M., & Goldberg, M.E. (1998).

The representation of visual salience in monkey parietal cortex. Nature, 391(6666), 481-4. [PubMed:9461214] [WorldCat] [DOI] - ↑

Thompson, K.G., & Bichot, N.P. (2005).

A visual salience map in the primate frontal eye field. Progress in brain research, 147, 251-62. [PubMed:15581711] [WorldCat] [DOI] - ↑

Reynolds, J.H., & Desimone, R. (2003).

Interacting roles of attention and visual salience in V4. Neuron, 37(5), 853-63. [PubMed:12628175] [WorldCat] [DOI] - ↑

Tseng, P.H., Cameron, I.G., Pari, G., Reynolds, J.N., Munoz, D.P., & Itti, L. (2013).

High-throughput classification of clinical populations from natural viewing eye movements. Journal of neurology, 260(1), 275-84. [PubMed:22926163] [WorldCat] [DOI] - ↑

Yoshida, M., Itti, L., Berg, D.J., Ikeda, T., Kato, R., Takaura, K., ..., & Isa, T. (2012).

Residual attention guidance in blindsight monkeys watching complex natural scenes. Current biology : CB, 22(15), 1429-34. [PubMed:22748317] [WorldCat] [DOI]

(執筆者:吉田正俊 担当編集委員:伊佐正)