報酬予測

望月泰博、陳冲、福田玄明、中原裕之

理化学研究所 脳科学総合研究センター 理論統合脳科学研究チーム

DOI:10.14931/bsd.7486 原稿受付日:2018年2月16日 原稿完成日:2018年3月9日

担当編集委員:田中啓治(理化学研究所 脳科学総合研究センター 認知機能表現研究チーム)

英:Reward prediction

報酬予測とは、ヒトを含む動物が、特定の情報から将来の報酬を予測することである。ここで「報酬」とは、食料・水などに代表される正の動機や感情を生む物質・出来事・状況・活動の総称であり、動物はより多くの報酬を得るために報酬を予測し、それにもとづく反応や行動選択をみせる。動物の脳では、報酬を予測する刺激の価値・報酬をもたらす行動の価値・報酬への期待のそれぞれを反映した神経活動が報告されており、これらの活動はドーパミンニューロンの活動を学習信号として調整されると考えられている。ここでは、動物がみせる報酬予測にもとづく反応と行動選択、そして報酬予測にかかわる神経活動について述べる。

報酬予測にかかわる行動

報酬(reward)の代表である食料・水は、動物の生存に不可欠であり、より多くの報酬を得るために反応・行動することは、種の存続に有利に働く。そのため、動物は特定の情報から報酬の獲得が予測できる状況にあっては報酬を予測し、それにともなう様々な反応と行動選択をみせる。

動物が実際に報酬を予測していることを示唆する反応や行動選択は、パブロフ型条件づけ(Pavlovian conditioning、または古典的条件づけ、classical conditioning)、道具的条件づけ(instrumental conditioning、またはオペラント条件づけ、operant conditioning)、また遅延反応課題(delayed response task)をはじめとする選択課題の実験に端的に表れる。報酬予測にかかわる神経活動を調べる際に用いられるのも、多くの場合これらの実験パラダイムである。以下では、パブロフ型条件づけ、道具的条件づけ、そして遅延反応課題の実験にみられる報酬予測に関連した反応と行動選択について説明する。

パブロフ型条件づけにみられる反応

パブロフ型条件づけの実験では、動物が報酬を予測していることを支持する受動的な反応がみられる。パブロフ型条件づけでは、動物は本来意味を持たない外界の情報(刺激)と報酬の連合を学習する。たとえば、有名な「パブロフの犬」の実験では、イヌがベルの音を聞いた直後に餌が与えられることを何度も経験するうちに、ベルの音を聞くだけでヨダレをだすようになる。これは、イヌがベルの音と餌の連合を学習したものと解釈できる。ここでは餌が報酬であり、無条件に(学習を必要とせず)ヨダレという反応を引き起こすことから、無条件刺激(unconditioned stimulus:US)と呼ばれる。また、ベルの音は学習の結果ヨダレの反応を引き起こすことから、条件刺激(conditioned stimulus:CS)と呼ばれる。動物が本来意味を持たないCSに対してUSによって引き起こされる反応を獲得することは、動物がCSをもとに報酬が得られることを予測するようになったためと考えられる。

さらに、パブロフ型条件づけの実験では、動物が報酬を期待していることを示す自発的反応がみられる。たとえば、CSが報酬を予想することを学習した動物は、CSの呈示に際してCSや報酬の呈示場所へ近づく接近反応(approach response)をみせる[1]。また、報酬としてジュースが与えられる課題では、動物が報酬を獲得する前に飲み口を予期的に舐めるリッキング行動がみられる[2]。これらの報酬獲得のための準備行動も、動物がCSにもとづき報酬を予測していることを支持している。

パブロフ型条件づけをはじめとした実験にみられる報酬予測に関連した反応は、強化学習のモデルを用いて説明することができる。ここでは、パブロフ型条件づけにおける動物の反応の数理モデルとして提唱された「レスコーラ・ワグナー・モデル(Rescorla–Wagner model)」の強化学習的解釈を紹介する[3] [4]。

レスコーラ・ワグナー・モデルでは、実際に得られた報酬量と予測された報酬量の差分である「報酬予測誤差(reward prediction error)」が学習信号となり、今までの予期報酬が新たな予期報酬へ更新される:

新たな予期報酬 = 今までの予期報酬 + 学習係数 × 報酬予測誤差

上式からわかるように、新たな予期報酬は、報酬予測誤差が正であれば(報酬が予想していたより多ければ)増加し、負であれば(報酬が予想していたより少なければ)減少する。

レスコーラ・ラワグナー・モデルは、パブロフ型条件づけの実験でみられる動物の反応をよく説明する。たとえば、光が点灯すると餌がもらえることを学習したラットに対し、光と音を同時に呈示した後に餌を与えることを繰り返しても、音に対する学習は起こらない。これは「阻止効果(blocking effect)」と呼ばれており[1]、レスコーラ・ラワグナー・モデルでは、先に学習された光が報酬の獲得を予測するため、音に予測される報酬の報酬予測誤差がゼロとなるからと解釈できる。

道具的条件づけにみられる自発的行動

道具的条件づけの実験では、動物が報酬を予測していることを支持する自発的な行動がみられる。道具的条件づけの実験パラダイムでは、特定の環境や刺激に対して動物がとる行動次第で報酬が得られるかどうかが決まる。このような実験課題で、動物はより大きな報酬をもたらす行動の頻度を増加させる。たとえば、ソーンダイクが行った実験では、パズルボックスの中に閉じ込められたネコが試行錯誤を繰り返すうちに、ボックスの内側に設置された紐を引き、外に出て餌を獲得することを学習する。報酬をもたらす行動の頻度が増加することは、動物が特定の行動の結果として報酬が得られることを学習したためと考えられる。

遅延反応課題にみられる行動選択と反応

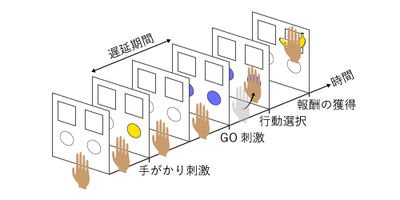

報酬予測に関連した行動選択を調べるためによく用いられる課題に、遅延選択課題がある(図1)。たとえば、サルが学習する典型的な遅延選択課題では、まず左右どちらかの手がかり刺激(cue stimulus)が点灯する。手がかり刺激が消えたあとGO刺激(GO stimulus)が点灯すると、サルには左右どちらかのボタンを押すことが求められる。このとき、刺激が呈示されたのと同じ側のボタンを押した場合には報酬として餌やジュースが与えられるが、逆側を押した場合には報酬が与えられない。

サルはこのような課題を繰り返すうちに、手がかり刺激に応じて左右のボタンを押し、報酬を得ることを学習する。さらに、サルの好物であるバナナを報酬として遅延選択課題を行った場合、報酬をレタスに変更すると、サルは驚きと怒りをみせる[6]。また、同様の実験パラダイムでサルが二種類の手がかり刺激がそれぞれ異なる種類のジュースを予測していることを学習した場合、サルは嗜好性の高い報酬が得られる試行において、より短い反応時間かつより高い正当率で行動選択を行い、予期的なリッキング行動をより長い時間続ける[7]。これらのことは、サルが特定の行動を選択した結果得られる報酬を予測していることを示している[5]。

報酬予測にかかわる神経活動

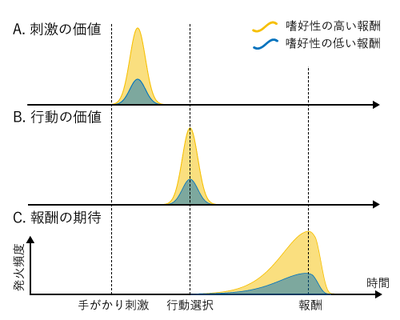

A. 報酬を予測する刺激の価値を反映したニューロンの活動。

B. 報酬をもたらす行動の価値を反映したニューロンの活動。

C. 報酬への期待を反映したニューロンの活動。黄色と青色は、同じニューロンがそれぞれ嗜好性の高い報酬と低い報酬が予測される試行でみせる活動。

報酬予測にかかわる神経活動は、一般に報酬系と呼ばれる脳領域群をはじめとして、多様な脳領域でみられる[2] [8] [9] [10] [11] [12] [13]。ここでは、報酬予測にかかわる神経活動を、報酬を予測する刺激の価値を反映した神経活動(図2A)、報酬をもたらす行動の価値を反映した神経活動(図2B)、動物の報酬への期待を反映した神経活動(図2C)に分類し[2] [8]、これらの神経活動がみられる領域を紹介する。そして最後に、報酬予測にかかわる神経活動を調整する学習信号と考えられているドーパミンニューロン(dopaminergic neuron)の活動を紹介する。

刺激や行動の価値の神経活動

動物の脳では、刺激や行動の「価値(value)」を反映するような神経活動が報告されている[2] [8] [9] [10] [14]。

パブロフ型条件づけでは、本来意味を持たない刺激が、報酬との連合が学習されることで、未来の報酬を予測する価値の高い情報となる。このような学習によって増加した刺激の価値を反映するように、報酬を予測する刺激が呈示された直後に予想される報酬の好ましさに応じて活動を増大させるニューロンがみつかっている(図2A)。

刺激の価値を反映した神経活動は、眼窩前頭皮質[15] [16] [17]、線条体[7] [18] [19] [20]、扁桃体[21] [22]、黒質緻密部[23]、上丘[24]などで報告されている。

また、道具的条件づけでは、本来意味を持たない行動が、報酬との連合が学習されることで、報酬をもたらす価値の高い行動となる。このような学習にともなう行動の価値の増加を反映するように、報酬をもたらす行動が遂行される前後で予想される報酬の好ましさに応じて活動を増大させるニューロンがみつかっている(図2B)。

行動の価値を反映した神経活動は、線条体[7] [20] [25] [26] [27] [28]、後頭頂皮質[29]などで報告されている。

また、刺激や行動の価値を反映した神経活動には、予測される報酬の量や好ましさの情報とともに、報酬を予測する刺激の知覚情報、あるいは報酬を獲得するための行動に関連した情報が符号化されている場合が多い[8] [10]。たとえば、サルが遅延反応課題を行う際の神経活動を線条体で計測した実験では、手がかり刺激が視野の対側に呈示される試行で活動を高めるニューロンがみつかっている[18] [26]。このような予測された報酬の情報および報酬獲得のための行動関連情報を含む神経信号は、報酬獲得のために適切な行動を遂行することを可能にしているものと考えられる[10]。

報酬期待の神経活動

これまでの多くの実験から、動物の報酬への期待を反映するような神経活動が報告されている[2] [8] [9] [10] [30]。報酬期待の神経活動は、報酬を予測する刺激が呈示された後、報酬が獲得されるまでの間に持続的に増大し、さらに活動の増大幅は予測された報酬の量や好ましさを反映するという特徴を持つ(図2C)。

報酬期待の神経活動がみられる脳領野は多岐にわたっている。大脳皮質下の領域では、線条体[18] [31] [32]、淡蒼球[33]、扁桃体[34]、上丘[24]、脚橋被蓋核[35]などで報酬期待の神経活動がみられる。また、大脳皮質では、背外側前頭前皮質[5] [36] [37]、眼窩前頭皮質[16] [34]、後頭頂皮質[38]、前帯状皮質[39]、島皮質[40]、運動前野[17] [37]などで報酬期待の神経活動が報告されている。

ドーパミンニューロンの活動と報酬予測誤差

ドーパミンニューロンのphasic活動は、強化学習で一般に報酬予測誤差と呼ばれる学習信号を符号化していると考えられており、これは「ドーパミン報酬予測誤差仮説(the dopamine reward prediction error hypothesis)」と呼ばれている[41] [42] [43]。ドーパミン報酬予測誤差仮説を支持する研究結果として、たとえば、サルのドーパミンニューロンの反応が学習に伴い変化することが知られている[41] [44]。ドーパミンニューロンは、学習の初期には報酬の獲得にあわせて活動を増大させる。この反応は学習が進むにつれ消失し、報酬を予測する手がかり刺激の呈示直後に活動が増大するようになる。また、予想された報酬が呈示されなかった場合には、報酬が予測された時刻の活動が低下する。これらのことは、ドーパミンニューロンが正負の報酬予測誤差を両方向的に符号化していることを示唆している[9]。さらに、阻止効果に関する実験でもドーパミンニューロンが強化学習の理論から予見される学習信号を反映した活動をみせることが確認されおり[45] [46]、またオプトジェネティクスを用いてドーパミンニューロンの活動を人為的に操作すると報酬予測に関連した学習が阻害されることも報告されている[47] 。

報酬予測誤差を反映したドーパミンニューロンの活動は、神経可塑性を介して脳における価値表現を調節すると考えられている。ドーパミンニューロンは、前述の刺激や行動の価値を反映した神経活動が報告されている脳領域の多くに投射しており[9] [10]、投射先のニューロンのシナプス強度はドーパミンニューロンが活動することで放出されるドーパミンによって調節される[48] [49]。

近年では、ドーパミンニューロンの他にも、線条体[50]や内側前頭前皮質[51]で報酬予測誤差を反映した活動をみせるニューロンが見つかっている。さらに、外側手綱核ではドーパミンニューロンとは逆に罰の予測に関連して負の報酬予測誤差を反映するニューロンの活動が報告されている[52]。これらの神経活動もなんらかの形で報酬予測に関連する神経活動の調整にかかわっているものと考えられるが、その詳細はまだわかっていない[2]。また、報酬予測誤差そのものが脳でどのように計算されているのかという問題も今後の重要な研究課題の一つといえるだろう[2] [53] [54] [55] [56]。

関連項目

参考文献

- ↑ 1.0 1.1 Mark E Bouton

Learning and behavior: A contemporary synthesis Second Edition

Sinauer Associates: 2007 - ↑ 2.0 2.1 2.2 2.3 2.4 2.5 2.6 筒井健一郎、大山佳

報酬期待の神経科学、社会脳シリーズ第5巻・報酬を期待する脳

苧坂直行編、新曜社: 2014 - ↑ Peter Dayan, L. F. Abbott

Theoretical Neuroscience: Computational and Mathematical Modeling of Neural Systems

The MIT Press: 2001 - ↑ Peter Dayan, Hiroyuki Nakahara

Models and Methods for Reinforcement Learning, The Stevens’ Handbook of Experimental Psychology

Wiley: 2017 - ↑ 5.0 5.1 5.2

Watanabe, M. (1996).

Reward expectancy in primate prefrontal neurons. Nature, 382(6592), 629-32. [PubMed:8757133] [WorldCat] [DOI] - ↑ O L Tinklepaugh

An experimental study of representative factors in monkeys.

J. Comp. Psychol.: 1928, (8);197-236 - ↑ 7.0 7.1 7.2

Hassani, O.K., Cromwell, H.C., & Schultz, W. (2001).

Influence of expectation of different rewards on behavior-related neuronal activity in the striatum. Journal of neurophysiology, 85(6), 2477-89. [PubMed:11387394] [WorldCat] [DOI] - ↑ 8.0 8.1 8.2 8.3 8.4 8.5

Schultz, W. (2015).

Neuronal Reward and Decision Signals: From Theories to Data. Physiological reviews, 95(3), 853-951. [PubMed:26109341] [PMC] [WorldCat] [DOI] - ↑ 9.0 9.1 9.2 9.3 9.4

Schultz, W. (2006).

Behavioral theories and the neurophysiology of reward. Annual review of psychology, 57, 87-115. [PubMed:16318590] [WorldCat] [DOI] - ↑ 10.0 10.1 10.2 10.3 10.4 10.5

Hikosaka, O., Nakamura, K., & Nakahara, H. (2006).

Basal ganglia orient eyes to reward. Journal of neurophysiology, 95(2), 567-84. [PubMed:16424448] [WorldCat] [DOI] - ↑

Haber, S.N., & Knutson, B. (2010).

The reward circuit: linking primate anatomy and human imaging. Neuropsychopharmacology : official publication of the American College of Neuropsychopharmacology, 35(1), 4-26. [PubMed:19812543] [PMC] [WorldCat] [DOI] - ↑

Rangel, A., Camerer, C., & Montague, P.R. (2008).

A framework for studying the neurobiology of value-based decision making. Nature reviews. Neuroscience, 9(7), 545-56. [PubMed:18545266] [PMC] [WorldCat] [DOI] - ↑

Rushworth, M.F., Noonan, M.P., Boorman, E.D., Walton, M.E., & Behrens, T.E. (2011).

Frontal cortex and reward-guided learning and decision-making. Neuron, 70(6), 1054-69. [PubMed:21689594] [WorldCat] [DOI] - ↑

O'Doherty, J.P., Cockburn, J., & Pauli, W.M. (2017).

Learning, Reward, and Decision Making. Annual review of psychology, 68, 73-100. [PubMed:27687119] [PMC] [WorldCat] [DOI] - ↑

Rolls, E.T., Critchley, H.D., Mason, R., & Wakeman, E.A. (1996).

Orbitofrontal cortex neurons: role in olfactory and visual association learning. Journal of neurophysiology, 75(5), 1970-81. [PubMed:8734596] [WorldCat] [DOI] - ↑ 16.0 16.1

Tremblay, L., & Schultz, W. (1999).

Relative reward preference in primate orbitofrontal cortex. Nature, 398(6729), 704-8. [PubMed:10227292] [WorldCat] [DOI] - ↑ 17.0 17.1

Roesch, M.R., & Olson, C.R. (2004).

Neuronal activity related to reward value and motivation in primate frontal cortex. Science (New York, N.Y.), 304(5668), 307-10. [PubMed:15073380] [WorldCat] [DOI] - ↑ 18.0 18.1 18.2

Kawagoe, R., Takikawa, Y., & Hikosaka, O. (1998).

Expectation of reward modulates cognitive signals in the basal ganglia. Nature neuroscience, 1(5), 411-6. [PubMed:10196532] [WorldCat] [DOI] - ↑

Kimura, M., Rajkowski, J., & Evarts, E. (1984).

Tonically discharging putamen neurons exhibit set-dependent responses. Proceedings of the National Academy of Sciences of the United States of America, 81(15), 4998-5001. [PubMed:6589643] [PMC] [WorldCat] [DOI] - ↑ 20.0 20.1

Cromwell, H.C., & Schultz, W. (2003).

Effects of expectations for different reward magnitudes on neuronal activity in primate striatum. Journal of neurophysiology, 89(5), 2823-38. [PubMed:12611937] [WorldCat] [DOI] - ↑

Nishijo, H., Ono, T., & Nishino, H. (1988).

Single neuron responses in amygdala of alert monkey during complex sensory stimulation with affective significance. The Journal of neuroscience : the official journal of the Society for Neuroscience, 8(10), 3570-83. [PubMed:3193171] [WorldCat] - ↑

Paton, J.J., Belova, M.A., Morrison, S.E., & Salzman, C.D. (2006).

The primate amygdala represents the positive and negative value of visual stimuli during learning. Nature, 439(7078), 865-70. [PubMed:16482160] [PMC] [WorldCat] [DOI] - ↑

Schultz, W. (1986).

Responses of midbrain dopamine neurons to behavioral trigger stimuli in the monkey. Journal of neurophysiology, 56(5), 1439-61. [PubMed:3794777] [WorldCat] [DOI] - ↑ 24.0 24.1

Ikeda, T., & Hikosaka, O. (2003).

Reward-dependent gain and bias of visual responses in primate superior colliculus. Neuron, 39(4), 693-700. [PubMed:12925282] [WorldCat] [DOI] - ↑

Samejima, K., Ueda, Y., Doya, K., & Kimura, M. (2005).

Representation of action-specific reward values in the striatum. Science (New York, N.Y.), 310(5752), 1337-40. [PubMed:16311337] [WorldCat] [DOI] - ↑ 26.0 26.1

Lauwereyns, J., Watanabe, K., Coe, B., & Hikosaka, O. (2002).

A neural correlate of response bias in monkey caudate nucleus. Nature, 418(6896), 413-7. [PubMed:12140557] [WorldCat] [DOI] - ↑

Watanabe, K., Lauwereyns, J., & Hikosaka, O. (2003).

Neural correlates of rewarded and unrewarded eye movements in the primate caudate nucleus. The Journal of neuroscience : the official journal of the Society for Neuroscience, 23(31), 10052-7. [PubMed:14602819] [PMC] [WorldCat] - ↑

Lau, B., & Glimcher, P.W. (2008).

Value representations in the primate striatum during matching behavior. Neuron, 58(3), 451-63. [PubMed:18466754] [PMC] [WorldCat] [DOI] - ↑

Sugrue, L.P., Corrado, G.S., & Newsome, W.T. (2004).

Matching behavior and the representation of value in the parietal cortex. Science (New York, N.Y.), 304(5678), 1782-7. [PubMed:15205529] [WorldCat] [DOI] - ↑

Liu, X., Hairston, J., Schrier, M., & Fan, J. (2011).

Common and distinct networks underlying reward valence and processing stages: a meta-analysis of functional neuroimaging studies. Neuroscience and biobehavioral reviews, 35(5), 1219-36. [PubMed:21185861] [PMC] [WorldCat] [DOI] - ↑

Schultz, W., Apicella, P., Scarnati, E., & Ljungberg, T. (1992).

Neuronal activity in monkey ventral striatum related to the expectation of reward. The Journal of neuroscience : the official journal of the Society for Neuroscience, 12(12), 4595-610. [PubMed:1464759] [WorldCat] - ↑

Hikosaka, O., Sakamoto, M., & Usui, S. (1989).

Functional properties of monkey caudate neurons. III. Activities related to expectation of target and reward. Journal of neurophysiology, 61(4), 814-32. [PubMed:2723722] [WorldCat] [DOI] - ↑

Tachibana, Y., & Hikosaka, O. (2012).

The primate ventral pallidum encodes expected reward value and regulates motor action. Neuron, 76(4), 826-37. [PubMed:23177966] [PMC] [WorldCat] [DOI] - ↑ 34.0 34.1

Schoenbaum, G., Chiba, A.A., & Gallagher, M. (1998).

Orbitofrontal cortex and basolateral amygdala encode expected outcomes during learning. Nature neuroscience, 1(2), 155-9. [PubMed:10195132] [WorldCat] [DOI] - ↑

Okada, K., Toyama, K., Inoue, Y., Isa, T., & Kobayashi, Y. (2009).

Different pedunculopontine tegmental neurons signal predicted and actual task rewards. The Journal of neuroscience : the official journal of the Society for Neuroscience, 29(15), 4858-70. [PubMed:19369554] [PMC] [WorldCat] [DOI] - ↑

Leon, M.I., & Shadlen, M.N. (1999).

Effect of expected reward magnitude on the response of neurons in the dorsolateral prefrontal cortex of the macaque. Neuron, 24(2), 415-25. [PubMed:10571234] [WorldCat] [DOI] - ↑ 37.0 37.1

Roesch, M.R., & Olson, C.R. (2003).

Impact of expected reward on neuronal activity in prefrontal cortex, frontal and supplementary eye fields and premotor cortex. Journal of neurophysiology, 90(3), 1766-89. [PubMed:12801905] [WorldCat] [DOI] - ↑

Platt, M.L., & Glimcher, P.W. (1999).

Neural correlates of decision variables in parietal cortex. Nature, 400(6741), 233-8. [PubMed:10421364] [WorldCat] [DOI] - ↑

Shidara, M., & Richmond, B.J. (2002).

Anterior cingulate: single neuronal signals related to degree of reward expectancy. Science (New York, N.Y.), 296(5573), 1709-11. [PubMed:12040201] [WorldCat] [DOI] - ↑

Mizuhiki, T., Richmond, B.J., & Shidara, M. (2012).

Encoding of reward expectation by monkey anterior insular neurons. Journal of neurophysiology, 107(11), 2996-3007. [PubMed:22402653] [PMC] [WorldCat] [DOI] - ↑ 41.0 41.1

Schultz, W., Dayan, P., & Montague, P.R. (1997).

A neural substrate of prediction and reward. Science (New York, N.Y.), 275(5306), 1593-9. [PubMed:9054347] [WorldCat] [DOI] - ↑

Glimcher, P.W. (2011).

Understanding dopamine and reinforcement learning: the dopamine reward prediction error hypothesis. Proceedings of the National Academy of Sciences of the United States of America, 108 Suppl 3, 15647-54. [PubMed:21389268] [PMC] [WorldCat] [DOI] - ↑ Nathaniel D. Daw, Philippe N. Tobler

Value Learning through Reinforcement: The Basics of Dopamine and Reinforcement Learning

In Neuroeconomics 2nd Edition, Edited by Paul W Glimcher & Ernst Fehr, Academic Press: 2014 - ↑

Mirenowicz, J., & Schultz, W. (1994).

Importance of unpredictability for reward responses in primate dopamine neurons. Journal of neurophysiology, 72(2), 1024-7. [PubMed:7983508] [WorldCat] [DOI] - ↑

Waelti, P., Dickinson, A., & Schultz, W. (2001).

Dopamine responses comply with basic assumptions of formal learning theory. Nature, 412(6842), 43-8. [PubMed:11452299] [WorldCat] [DOI] - ↑

Nakahara, H., Itoh, H., Kawagoe, R., Takikawa, Y., & Hikosaka, O. (2004).

Dopamine neurons can represent context-dependent prediction error. Neuron, 41(2), 269-80. [PubMed:14741107] [WorldCat] [DOI] - ↑

Schultz, W., Stauffer, W.R., & Lak, A. (2017).

The phasic dopamine signal maturing: from reward via behavioural activation to formal economic utility. Current opinion in neurobiology, 43, 139-148. [PubMed:28390863] [WorldCat] [DOI] - ↑

Reynolds, J.N., Hyland, B.I., & Wickens, J.R. (2001).

A cellular mechanism of reward-related learning. Nature, 413(6851), 67-70. [PubMed:11544526] [WorldCat] [DOI] - ↑

Yagishita, S., Hayashi-Takagi, A., Ellis-Davies, G.C., Urakubo, H., Ishii, S., & Kasai, H. (2014).

A critical time window for dopamine actions on the structural plasticity of dendritic spines. Science (New York, N.Y.), 345(6204), 1616-20. [PubMed:25258080] [PMC] [WorldCat] [DOI] - ↑

Oyama, K., Hernádi, I., Iijima, T., & Tsutsui, K. (2010).

Reward prediction error coding in dorsal striatal neurons. The Journal of neuroscience : the official journal of the Society for Neuroscience, 30(34), 11447-57. [PubMed:20739566] [PMC] [WorldCat] [DOI] - ↑

Matsumoto, M., Matsumoto, K., Abe, H., & Tanaka, K. (2007).

Medial prefrontal cell activity signaling prediction errors of action values. Nature neuroscience, 10(5), 647-56. [PubMed:17450137] [WorldCat] [DOI] - ↑

Matsumoto, M., & Hikosaka, O. (2007).

Lateral habenula as a source of negative reward signals in dopamine neurons. Nature, 447(7148), 1111-5. [PubMed:17522629] [WorldCat] [DOI] - ↑

Cohen, J.Y., Haesler, S., Vong, L., Lowell, B.B., & Uchida, N. (2012).

Neuron-type-specific signals for reward and punishment in the ventral tegmental area. Nature, 482(7383), 85-8. [PubMed:22258508] [PMC] [WorldCat] [DOI] - ↑

Nakamura, K., Santos, G.S., Matsuzaki, R., & Nakahara, H. (2012).

Differential reward coding in the subdivisions of the primate caudate during an oculomotor task. The Journal of neuroscience : the official journal of the Society for Neuroscience, 32(45), 15963-82. [PubMed:23136434] [PMC] [WorldCat] [DOI] - ↑

Nakahara, H., & Hikosaka, O. (2012).

Learning to represent reward structure: a key to adapting to complex environments. Neuroscience research, 74(3-4), 177-83. [PubMed:23069349] [PMC] [WorldCat] [DOI] - ↑

Nakahara, H. (2014).

Multiplexing signals in reinforcement learning with internal models and dopamine. Current opinion in neurobiology, 25, 123-9. [PubMed:24463329] [WorldCat] [DOI]